categoria: Distruzione creativa

Come ammazzare Asimov e le leggi sui robot! (con i riflessi sull’economia)

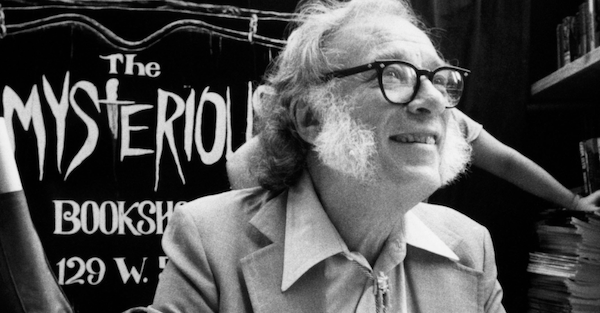

Il 2 gennaio 1920 (giusto ierii), nasceva Isaac Asimov, un valido scienziato, divenuto poi un famoso scrittore di fantascienza. Tralasciando tutta la sua bibliografia mi concentrerò su quello che è uno dei suoi maggiori contributi al futuro che oggi viviamo: le relazioni uomo macchina (che lui definì robot, oggi potremmo parlare, con maggior libertà, di Intelligenza Artificiale).

Leggo il 2 gennaio, il giorno del suo compleanno, un’analisi che, per quanto parta bene, poi mi lascia il sapore amaro in bocca. Il direttore dell’Istituto Italiano di Tecnologia parla di Asimov citando l’importanza delle sue “Leggi della Robotica”. Fin qui tutto bene. Solo che il direttore parla di 3 leggi mentre Asimov, come risaputo, verso la fine della sua vita scrisse una ulteriore legge: la 4a, spesso rinominata come legge 0. Premetto che questa discussione parte filosofica ma diventerà molto economica. Per correttezza vi sono differenti discussioni (cito quella della Cornell University come link) dove si discute della effettiva utilità delle leggi di Asimov. Si suppone che durante la mia vita (quindi entro i prossimi 40 anni, salvo che mi accada qualcosa prima) una Intelligenza Artificiale (generalmente ci si riferisce ad essa anche come “singolarità”) passerà il test di Turing. Allo stato attuale il concetto di Intelligenza artificiale (se ci rifacciamo al test di Turing) è ancora di là da venire. Resta comunque vitale, sin da oggi, definire che confini morali ed etici, e per conseguenza comportamentali, questa intelligenza dovrà avere. Di qui la citazione delle 3 leggi di Asimov da parte di scienziati, filosofi, giornalisti, gente di marketing e pr.

Le Leggi di Asimov

Prima Legge: “Un robot (oggi diremo un’IA) non può recar danno a un essere umano né può permettere che a causa del proprio mancato intervento un essere umano riceva danno”.

Seconda legge: “Un robot (oggi diremo un’IA) deve obbedire agli ordini impartiti dagli esseri umani purché tali ordini non contravvengano alla prima legge”.

Terza legge: “Un robot (oggi diremo un’IA) deve proteggere la propria esistenza purché questo non contrasti con la prima e la seconda legge”.

Successivamente l’autore di “Io Robot (da cui han tratto anche un film, che suggerisco di vedere, per le implicazioni estreme che la 4° legge può avere)” ne aggiungerà una quarta, superiore per importanza a tutte le altre ma valida solo per i robot più sofisticati (in teoria una super IA, ma su questo tema ancora si dibatte).

Legge zero: “Un robot non può recar danno all’umanità e non può permettere che, a causa di un suo mancato intervento, l’umanità riceva danno”.

Sino ad ora, lo ammetto, la discussione è un poco nerd. Non nego di essere appassionato di fantascienza: tuttavia ne sono appassionato proprio per capire come gli scrittori di fantascienza (che spesso sono anche giornalisti, scienziati, sociologi etc…) cercano di interpretare il futuro, partendo dal presente. Come dire: cercare di capire se il seme piantato oggi darà, negli anni, vita a una pianta perfettamente sana e dritta oppure storta, magari malata. Per spiegare l’importanza delle 3 leggi e la ricaduta che ha la 4a dovrò estremizzare la discussione ed applicarla a uno scenario economico ipotetico. Devo premettere che stiamo parlando di esempi futuri. Siamo in un campo teorico che, come hanno dimostrato altri scrittori di fantascienza in passato, richiede grande visione di insieme. è bene ricordare, infatti, che prevedere il futuro, o una parte di esso, non è cosa da tutti (Arthur Clarke e le orbite geostazionarie, tanto per dirne una). Dopo tutto non sorprende che molto spesso i migliori futuristi, assunti dalle aziende di spessore globale, siano anche scrittori di fantascienza.

Lo scenario base

Si consideri un’Intelligenza Artificiale che viene installata nei server di una grande azienda. Tale azienda offre servizi e prodotti al mercato finale (consumatore). Usiamo l’esempio, ma senza alcun riferimento al presente, di una multinazionale che vende veicoli per trasportare cose e persone. Nei servizi e prodotti da essa commercializzata rientrano: le auto/furgoni/motrici complete, i pezzi di ricambio, le soluzioni energetiche (magari elettriche o ibride) che li alimentano, le soluzioni finanziarie per l’acquisto del veicolo (e le relative banche e finanziarie gestite o partecipate dalla azienda) e tutta la filiera di fornitori e sub fornitori sparsi per il mondo.

Scenario 1: nessuna legge installata nella IA

Un’Intelligenza Artificiale libera da ogni legame etico e morale; solo limitata dal rispetto delle singole leggi nazionali. Casi di programmazione di algoritmi che hanno già violato le leggi ne abbiamo: dall’algoritmo maschilista di Amazon a quelli discriminatori di Apple / Goldman Sachs. Ma cosa succede se un’IA interagisce sull’intera filiera della azienda di automotive? Semplice: il suo unico mandato sarà di sfruttare il più possibile ogni passaggio della filiera per massimizzare il profitto. Pur ipotizzando che abbia inserito un codice di leggi per ogni nazione dove opera, potrà trovare soluzioni creative per eludere il sistema: dalla creazione di shell company sofisticate per non pagare le tasse (a danno degli stati dove la multinazionale è attiva e dovrebbe pagare le tasse), a strategie di acquisizione di risorse (materie prime, personale di ricerca etc..) pagandole il meno possibile, attivando processi di produzione che, seppur non illegali (a seconda delle nazioni) potrebbero sfociare in danni all’ambiente, alle persone ed a intere economie.

Per darvi un’idea ricordiamo che le leggi sulla tutela dei lavoratori in Asia sono differenti rispetto a quelle occidentali. La violazione delle leggi sul lavoro in Asia ha dei parametri diversi (più ampli diremmo noi) rispetto a quelli occidentali europei. Ma, e qui sta il bello: una IA spregiudicata, pur rispettando le leggi locali, potrebbe ripianificare l’intera filiera in tal senso spostando la produzione dove fa “più comodo”. Lo stesso dicasi per la vendita e il pagamento al cliente finale. Dove la IA potrebbe ipotizzare scenari di utilizzo e recupero crediti estremi: fermare l’auto (controllata in tempo reale da una “mini” IA legata all’IA aziendale) in mezzo alla strada. Il tutto per massimizzare il profitto: non una cosa nuova per le aziende ma se spinto all’estremo, da una IA altamente evoluta, questa ricerca del profitto potrebbe avere un effetto a scalare (quindi fattori che si sommano tra loro) devastante per il pianeta e la società.

Scenario 2: Un’intelligenza artificiale che opera seguendo le 3 leggi

Un’IA che dovrà decidere come impostare la filiera di approvvigionamento di materie prime, semi lavorati etc… sarà obbligata a considerare la prima legge e le altre 2. In tal senso non si avrà mai, per esempio, delle batterie per auto con terre rare estratte in Cina. L’estrazione del Neodimio, per esempio, avviene per la maggioranza in Cina. L’estrazione e la processazione a Bajan Obo, uno dei siti più importanti se parliamo di Neodimio (che finisce nelle auto elettriche verdi che “non danneggiano l’ambiente”) implica danni agli umani a livello genetico. Un pò come dire se respiri tutto il giorno l’amianto, o passi la giornata a estrarre in miniera carbone, prima o poi la silicosi te la prendi e ci muori. Un’IA andrà anche a vietare l’acquisto di altri minerali al cui estrazione, per mantenere i costi bassi, è spesso fatta eseguire a bambini: amico cobalto e amico tantalio ne conosciamo vero? Un mondo ideale, quello dove una IA con le 3 leggi opera, in cui nessun uomo sarà danneggiato ne da una macchina ne da altri uomini. In questo caso infatti stante le tre leggi la IA interverrà in modo contenitivo per evitare il danno. Sarebbe da discutere il concetto di danno di un umano, se si tratta solo di un danno fisico o anche mentale: dallo stress alla sindrome post traumatica. In questo caso un’IA di un azienda, se parliamo anche di danni psicologici, dovrebbe agire al meglio per non recare stress eccessivo agli umani che governa direttamente (come dipendenti dell’azienda) o indirettamente (la filiera di fornitori).

Scenario 3. Una IA che governa un azienda utilizzando le 4 leggi

Lo scenario all’apparenza è come quello precedente ma si configura in una modalità estremamente più protettiva, a rischio di danneggiare l’individuo a vantaggio dell’umanità. Poniamo qualche esempio sulla filiera. Se la IA può sacrificare alcuni esseri umani a beneficio di proteggere l’umanità una serie di azioni di approvvigionamento non saranno più accettabili. Un essere umano che danneggia l’ambiente per estrarre più materie prime, pur se compliant con le leggi locali, sarebbe un fornitore ideale dell’azienda? Difficile crederlo. E cosa dire di un manager dell’azienda che per massimizzare i profitti fa operazioni finanziare che possono recare danno ad altre persone o intere nazioni o categorie di persone (subprime e prestiti per auto concessi come se piovessero senza due diligence ne conosciamo vero?). Un dipendente così “scellerato” dovrebbe essere neutralizzato dalla azienda stessa. Se poi estendiamo il concetto di umanità, come un’entità che prolifera all’interno di un ambiente più complesso (globo terracqueo), cosa succede se le attività estrattive o di trasporto danneggiano, poniamo, flora e fauna?

Per quanto l’IA non abbia un diretto contatto con la sfera “non umana” del mondo, per proteggere l’umanità dovrebbe prevedere soluzioni di produzione, trasporto e usufrutto dei beni prodotti dalla stessa azienda che non rechino danno alla flora fauna e all’atmosfera. Diversamente tali danni, se cumulati, potrebbero portare a cambiamenti climatici (oggi ne abbiamo?) oppure scarsità di risorse alimentari che, sul lungo, vanno a danneggiare l’umanità stessa. Per assurdo la stessa IA potrebbe valutare che per funzionare in modo più efficiente sarebbe necessario solo una ridotta parte della forza lavoro e, sempre per non danneggiare l’uomo ed esporlo a rischi inutili, automatizzare una serie di processi fisici e virtuali ( finanza etc…)… il tutto con ricadute di disoccupazione importanti.

La differenza tra lo scenario 2 e 3

Come vedete le implicazioni della 4a legge di Asimov, per quanto semi-sconosciuta a molti, sono un aspetto che cambia radicalmente le leggi del gioco, quando parliamo di IA. Comprendere effettivamente le 4 leggi di Asimov e la loro, ipotetica, bene inteso, integrazione nella programmazione di IA è vitale per l’economia di intere nazioni, dei suoi politici e dell’umanità. Diversamente se volete andare sul leggero potete chiamare Skynet, e lui risolverà i problemi dell’umanità in un lampo….

Vuoi parlarne con me?

Sono @EnricoVerga su Twitter oppure trovami su LinkedIn